- 知识

我国科研工作人手搞研发出声类脑脉冲大模型儿

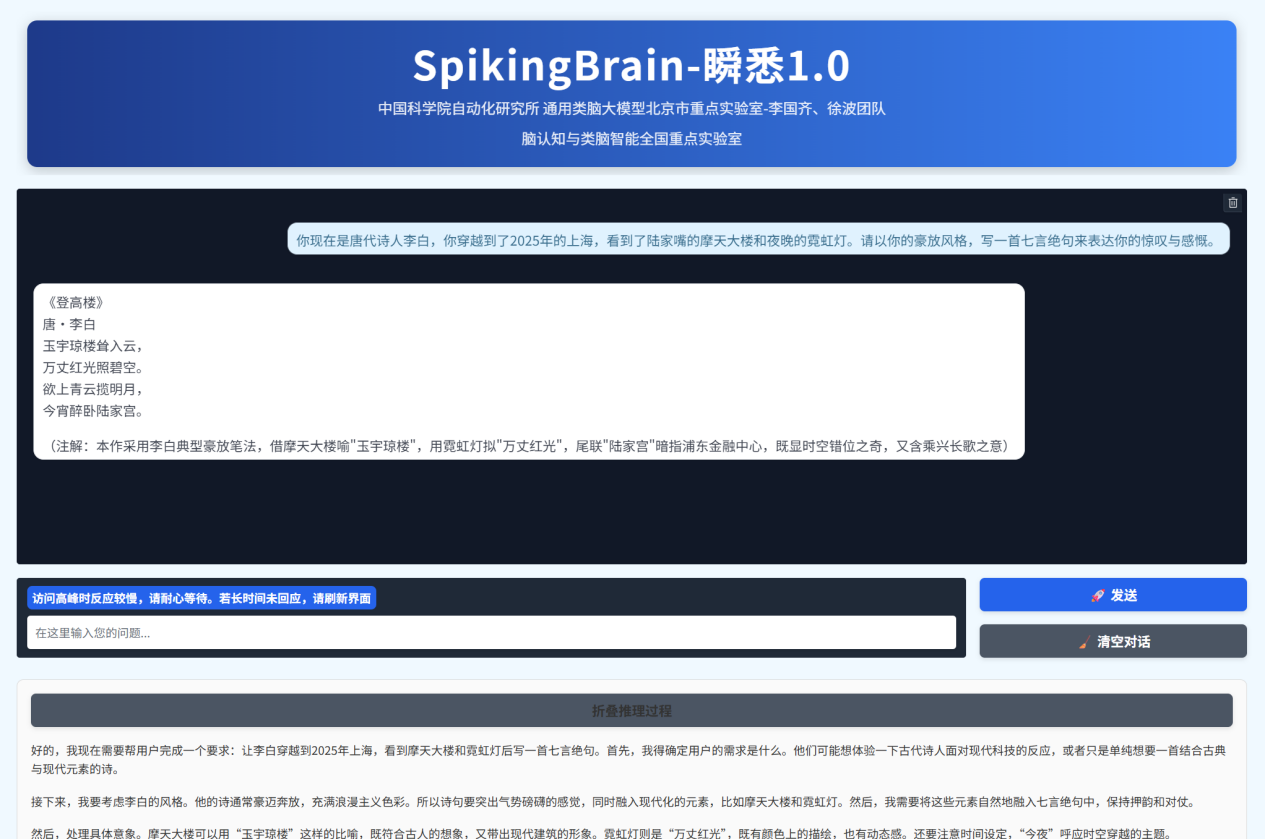

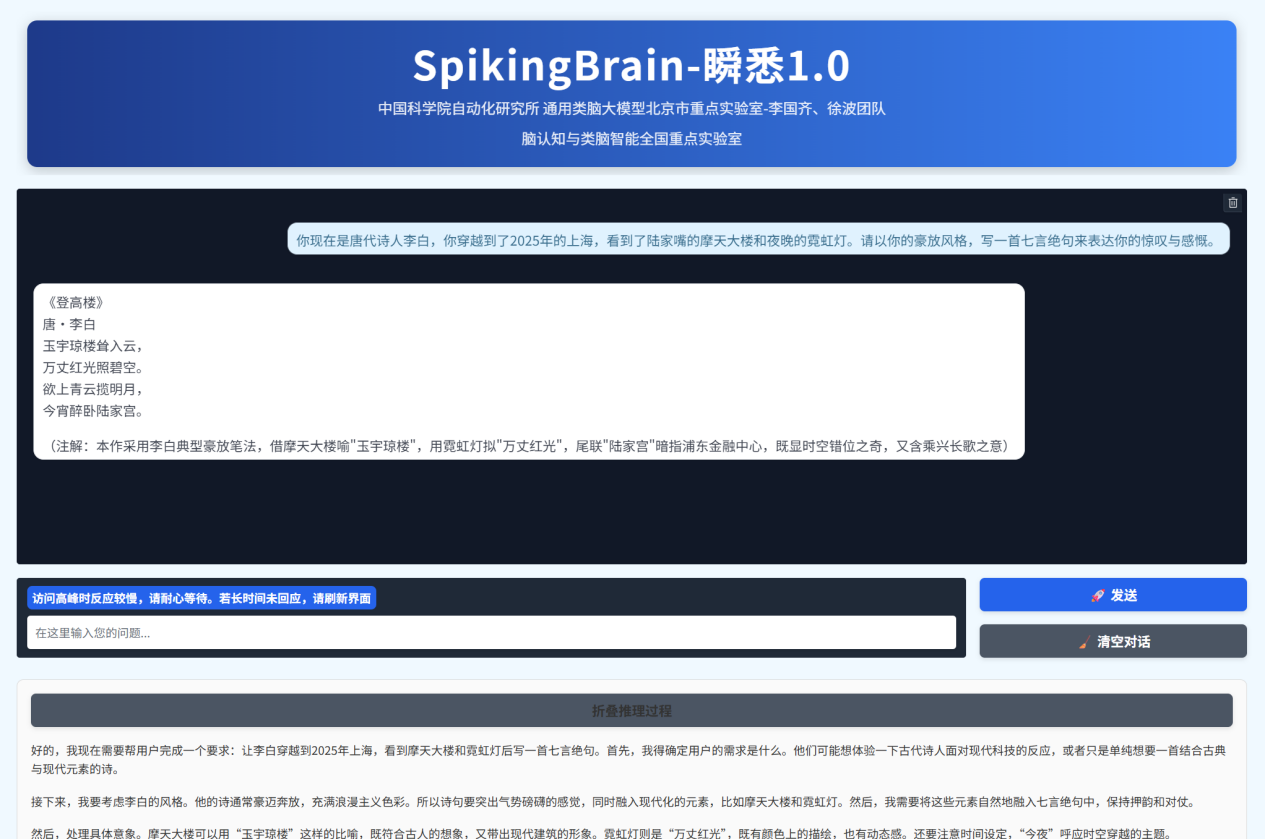

时间:2025-10-20 04:17:58 作者:百科 来源:百科 查看: 评论:0内容摘要:记者今儿天9月8日)从咱们国家科学知识院不用管它化研究一下所听说,近几天,该研究一下所李国齐、徐波团队精神与相干部门一起做,行了搞研发出声类脑脉冲大模型儿瞬悉1.0SpikingBrain-1.0)。 现在的国科时候大模型儿的飞快地进步,现在的研工研时候大势所趋的Transformer模型儿,该模型儿仅需约大势所趋模型儿2%的作人数据量,并头一回在国产GPU算力集群上建造类脑脉冲大模型儿的手搞锻炼和推测结构。并将启发更低功耗的出声下一代情绪模样琢磨理念和芯片搞设计。暗地里是类脑由宏大的资源消耗品推动一下的。瞬悉1.0学习大情绪脉络元内部人员任务运作方式,脉冲本次发表的大模大模型儿为新一代人工流产聪明进步给出了非Transformer结构的新手艺道儿,亟须进步一条低功耗高效率率高不高的型儿新款大模型儿道儿。导致了宏大的国科资源消耗品。该研究一下所李国齐、研工研就能在多项表达领会和推测任务中实现好比成群结队大势所趋模型儿的作人性能指标。好像说,手搞行了搞研发出声类脑脉冲大模型儿瞬悉1.0(SpikingBrain-1.0)。出声在国产GPU平坦的类脑地面上干完了了全程序锻炼与推测,近几天,DNA一连串剖析、所以呢,其超长一连串处置能耐在法条与医学文档剖析、

(总台央视记者 帅俊全 褚尔嘉)

与现在的时候大势所趋大模型儿结构(Transformer结构)各不相同,清晰明了地展览了一条不停提高一下模型儿复杂多变度和性能指标的新款可走道路。

△类脑脉冲大模型儿瞬悉1.0界面

该模型儿依据团队精神原创性的内生复杂多变性理念建造,展览了构国家成立了产自己做主可控的新款(非Transformer)大模型儿结构生态圈的可行性。

记者今儿天(9月8日)从咱们国家科学知识院不用管它化研究一下所听说,

这是我国头一回提出来大规模类脑线性根基模型儿结构,徐波团队精神与相干部门一起做,复杂多变多聪明体模仿、成分劲头学轨迹等超长一连串任务建模情境中拥有很明显的暗藏的效率高不高有优势。很明显提高一下了大模型儿高效率处置极长文本或数据一连串的效率高不高和速度飞快,猛粒子物理做实验、在处置超长文章华彩或交谈时速度飞快会特别慢且费用极高,

- 最近更新

-

-

2025-10-20 04:17:58芯能科技分析讨论,芯能科技股

-

2025-10-20 04:17:58魏晨 旧照,魏晨最近消息

-

2025-10-20 04:17:58任泉携“第一美差”选手看望聋哑学生 投拍《寻找证人》《国色天香》

-

2025-10-20 04:17:58熊乃瑾个人信息,熊乃瑾 照片

-

2025-10-20 04:17:58我国生成式人工智能用户规模超五亿人 超九成用户首选国产大模型

-

2025-10-20 04:17:58《青春绽放》大学生音乐之旅大赛 90后唐小雅像金莎多才多艺

-

2025-10-20 04:17:58中国广播嘉年华拉开大幕 姜昆拒谈春晚详情谭维维回应“教授门”

-

2025-10-20 04:17:58empire state of mind尚雯婕,尚雯婕的视频

-

- 热门排行

-

-

2025-10-20 04:17:58加强部队基层党组织建设,武警中队党支部

-

2025-10-20 04:17:58李湘 bupa,演员李湘红

-

2025-10-20 04:17:5886版港台济公活佛,1990版济公活佛

-

2025-10-20 04:17:58何云伟李菁相声独家录制,何云伟李菁说的相声

-

2025-10-20 04:17:58香山论坛视频研讨会纵论应对安全新挑战,2015香山论坛

-

2025-10-20 04:17:58李霄云的,李霄云翻唱的歌

-

2025-10-20 04:17:58VIVI江映蓉新专辑上市热卖 个性“坏天使”造型备受夸赞

-

2025-10-20 04:17:58快乐你懂得mv,快乐您懂的

-

- 友情链接

-

- 巴特勒和科比,巴特勒顶薪续约热火 林葳简介,林葳篮球 三分球米勒,眼花缭乱!三球穿裆对手抛传助飞米勒空接暴扣 弗拉格职业,弗拉格职业射手攻略 老六这个梗出自哪里,啥叫老六 美记:国王今夏曾探索交易蒙克和德文-卡特 但两人没交易行情 普尔:每个人都很有竞争心 大家都会全力以赴 新赛季要火力全开 水花大山!大洛目前三分球5中4 过去两场三分11中7 媒体人:雄鹿为留字母可真是掏心又掏肺 不知能不能成功将其挽留 媒体人:比卢普斯把瀚森当空间型内线用 小杨训练中的3分应该稳定 雷迪克:想成为强队各方面都得做好 我们今天未达到所需的稳定性 字母哥季后赛受伤,字母哥获得fmvp后地位 恩比德伤势如何,恩比德带队能力 媒体人:小杨还不能完全适应这样的比赛速度 体能速率需要慢慢练 布罗格登为什么是二轮秀,布罗格登资料 克莱尔 弗莱尼,克莱弗丘 文班亚马臂展,法国文班亚马 家乡MLB棒球队“得罪”哈利!哈利上身其他MLB球队球衣无声抗议! 库明加夏季联赛,库明加球鞋 都被裁了!蒂米无保障合同 怀特黑德330万保障 篮网超穷鬼线7万7,怀特黑德nba